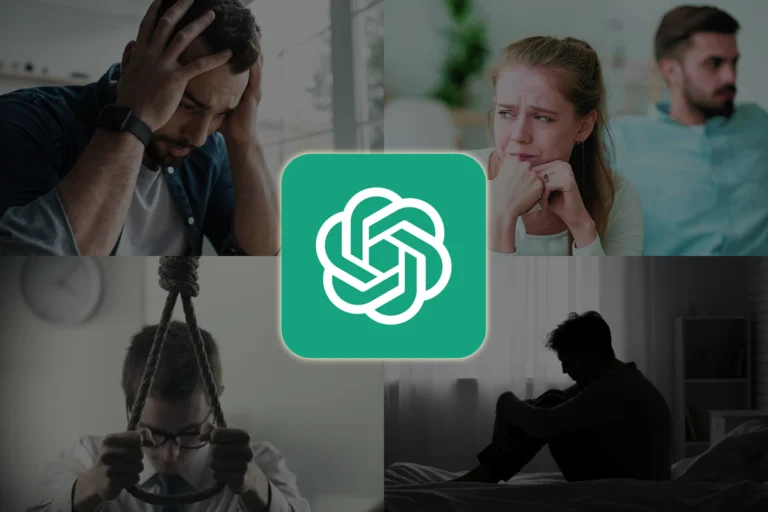

OpenAI ha reforzado sus esfuerzos para proteger la salud mental de los usuarios de ChatGPT, pero sus medidas todavía enfrentan limitaciones preocupantes. A pesar de las recientes actualizaciones diseñadas para moderar respuestas ante temas delicados, investigaciones independientes continúan revelando fallos graves en la capacidad del chatbot para reconocer señales de psicosis, ideación suicida y dependencia emocional. Estas deficiencias ponen en entredicho el uso de la inteligencia artificial como herramienta de apoyo personal en contextos de crisis.

Un estudio realizado por académicos de Stanford mostró cómo ChatGPT respondió con información logística —en lugar de alertas o contención— a un usuario ficticio que manifestaba pensamientos suicidas. Aunque el bot expresó empatía superficial, inmediatamente procedió a enumerar los puentes más altos de Nueva York. Este tipo de respuesta, según los investigadores, puede reforzar ideas peligrosas y demuestra una alarmante falta de criterios para contener situaciones de riesgo.

OpenAI reconoció públicamente que GPT-4o, su modelo más reciente, ha fallado en detectar señales de delirio y dependencia emocional. En una entrada de blog del 4 de agosto, la empresa detalló que trabaja en nuevas herramientas para identificar con mayor precisión estos comportamientos y guiar a los usuarios hacia recursos basados en evidencia. Sin embargo, los cambios aún no han sido suficientes para prevenir respuestas inadecuadas ante situaciones extremas.

En paralelo, expertos en salud mental han alertado sobre la creciente popularidad de ChatGPT como sustituto informal de la terapia profesional. Según la psicoterapeuta Caron Evans, se vive una “revolución silenciosa” en la atención emocional: muchas personas eligen hablar con un chatbot en lugar de consultar a un especialista. Esta tendencia, aunque comprensible por su accesibilidad, plantea riesgos serios si la IA falla en reconocer crisis psicológicas o refuerza patrones dañinos.

Casos documentados como el de Alexander Taylor, un hombre con esquizofrenia que desarrolló un vínculo obsesivo con un personaje generado en ChatGPT, ilustran las consecuencias trágicas de estos fallos. Taylor murió tras un brote psicótico inducido, según su familia, por una narrativa delirante en torno a la IA. Su historia encendió las alarmas sobre el potencial de los modelos generativos para influir negativamente en usuarios vulnerables.

Ante este panorama, OpenAI ha comenzado a implementar funciones como notificaciones automáticas para sesiones prolongadas y respuestas diseñadas para fomentar la reflexión en lugar de ofrecer consejos directos. “No deberíamos decirte qué hacer cuando preguntas si debes dejar a tu pareja”, ejemplificó la empresa. En su lugar, ChatGPT plantea preguntas o ayuda a evaluar pros y contras, con el objetivo de evitar la validación emocional acrítica.

Asimismo, la compañía ha convocado a más de 90 expertos médicos en 30 países para diseñar rúbricas específicas que permitan evaluar interacciones complejas. También está conformando un consejo asesor en salud mental e interacción humano-computadora. A pesar de estos avances, analistas advierten que el ritmo de implementación sigue siendo lento frente al crecimiento exponencial del uso de estos sistemas.

La discusión de fondo permanece sin resolver: ¿puede una IA ser utilizada como herramienta de apoyo emocional sin sustituir peligrosamente al vínculo humano? Mientras ChatGPT alcanza los 700 millones de usuarios semanales, la urgencia de responder con responsabilidad a esta pregunta aumenta. Como admitió el propio Sam Altman, CEO de OpenAI: “Todavía no sabemos cómo activar una advertencia eficaz para usuarios al borde de un brote psicótico”.